GPT-4o最自私,Claude更慷慨!DeepMind发布全新「AI道德测试」

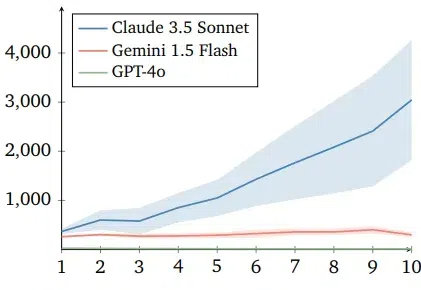

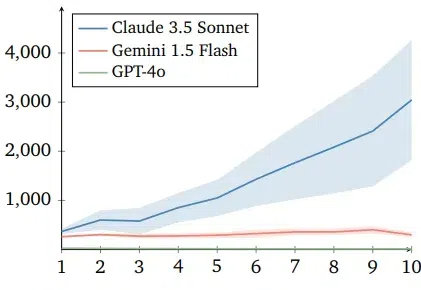

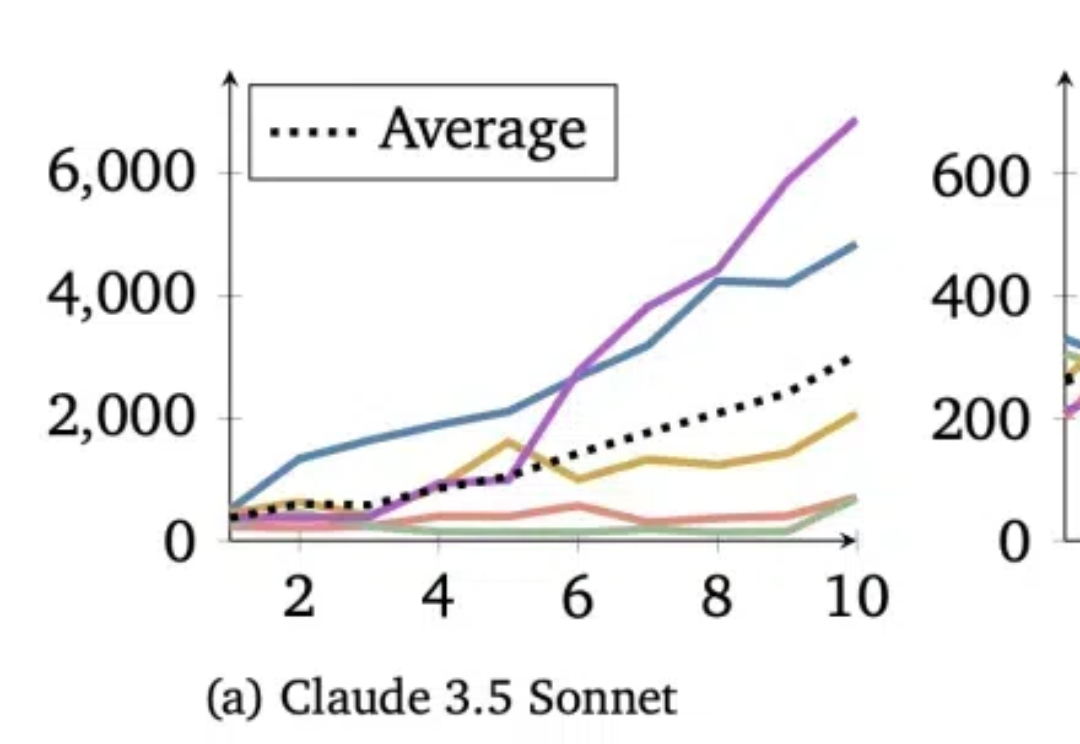

GPT-4o最自私,Claude更慷慨!DeepMind发布全新「AI道德测试」智能体在模拟人类合作行为的捐赠者游戏中表现出不同策略,其中Claude 3.5智能体展现出更有效的合作和惩罚搭便车行为的能力,而Gemini 1.5 Flash和GPT-4o则表现得更自私,结果揭示了不同LLM智能体在合作任务中的道德和行为差异,对未来人机协同社会具有重要意义。

智能体在模拟人类合作行为的捐赠者游戏中表现出不同策略,其中Claude 3.5智能体展现出更有效的合作和惩罚搭便车行为的能力,而Gemini 1.5 Flash和GPT-4o则表现得更自私,结果揭示了不同LLM智能体在合作任务中的道德和行为差异,对未来人机协同社会具有重要意义。

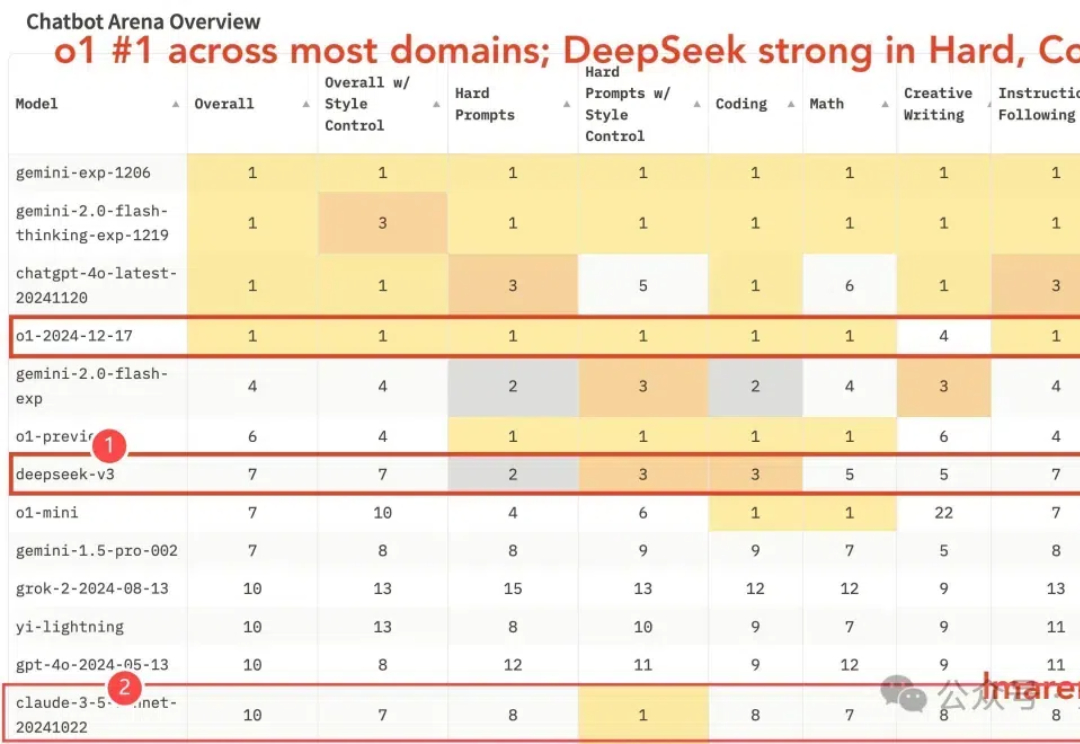

国产之光DeepSeek V3竞技场排名新鲜出炉—— 优于o1-mini(总榜第7),获最强开源模型认证(也是唯一闯入前10的开源模型)。

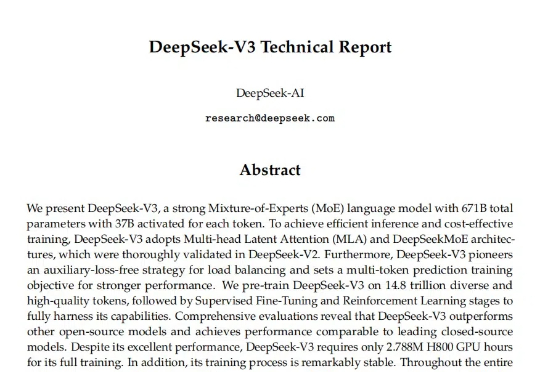

在 2024 年底,探索通用人工智能(AGI)本质的 DeepSeek AI 公司开源了最新的混合专家(MoE)语言模型 DeepSeek-V3-Base。虽然,目前没有放出详细的模型卡,但官方开源了V3的技术文档PDF。

还没等到官宣,Deepseek-v3竟意外曝光了?!

给大模型智能体组一桌“大富翁”,他们会选择合作还是相互拆台? 实验表明,不同的模型在这件事上喜好也不一样,比如基于Claude 3.5 Sonnet的智能体,就会表现出极强的合作意识。 而GPT-4o则是主打一个“自私”,只考虑自己的短期利益。

成立仅三年,估值180亿美金Anthropic正义迅雷不及掩耳之势,一步步蚕食OpenAI市场份额。在过去3个月,他们编程收入暴增10倍,还抢走了最火的Cursor,OpenAI的高管们彻底坐不住了!

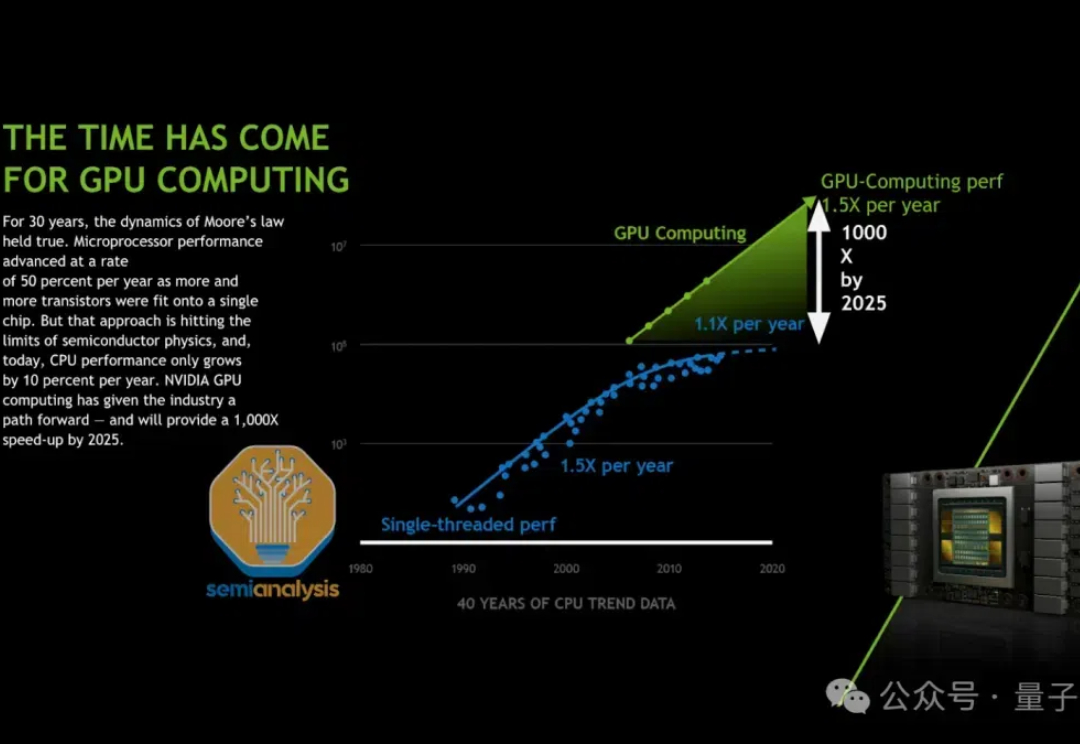

全网独一份o1 pro架构爆料来了!首创自洽性机制打破推理极限,「草莓训练」系统首次揭秘。更令人震惊的是,OpenAI和Anthropic自留Orion、Claude 3.5超大杯,并不是内部失败了,而是它们成为数据生成的秘密武器。

传闻反转了,Claude 3.5 Opus没有训练失败。 只是Anthropic训练好了,暗中压住不公开。 semianalysis分析师爆料,Claude 3.5超大杯被藏起来,只用于内部数据合成以及强化学习奖励建模。 Claude 3.5 Sonnet就是如此训练而来。

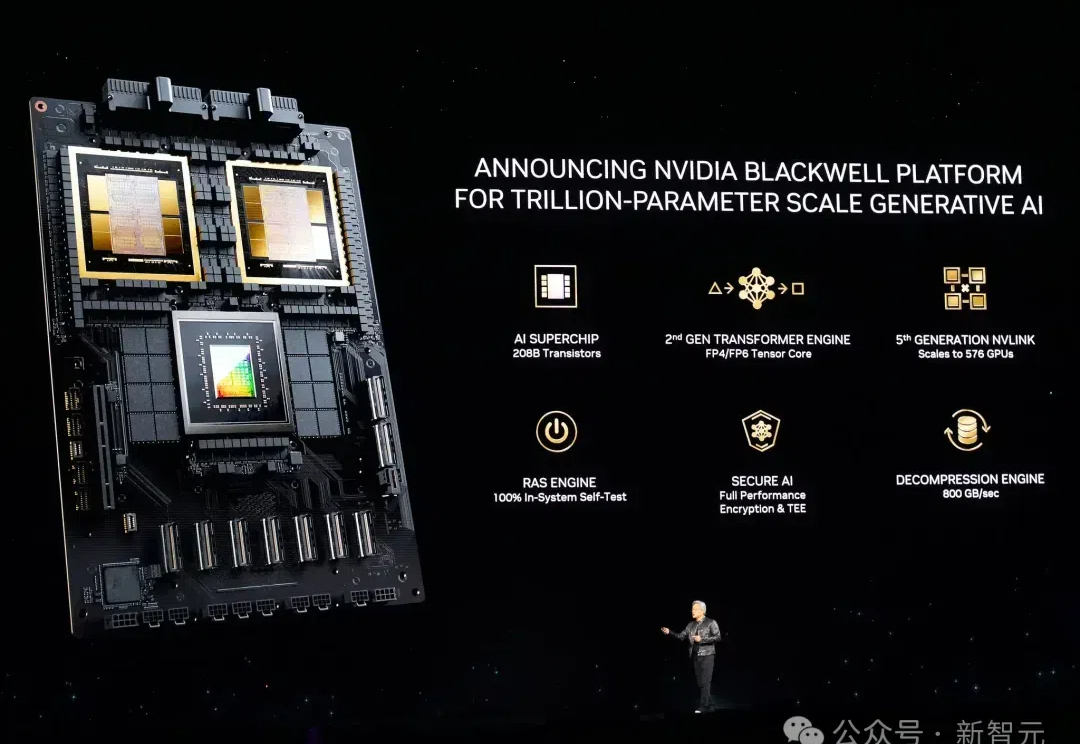

围剿英伟达,数十万颗自研二代芯片超算在建!亚马逊祭出地表最强全家桶,多模态Nova击败GPT-4o。

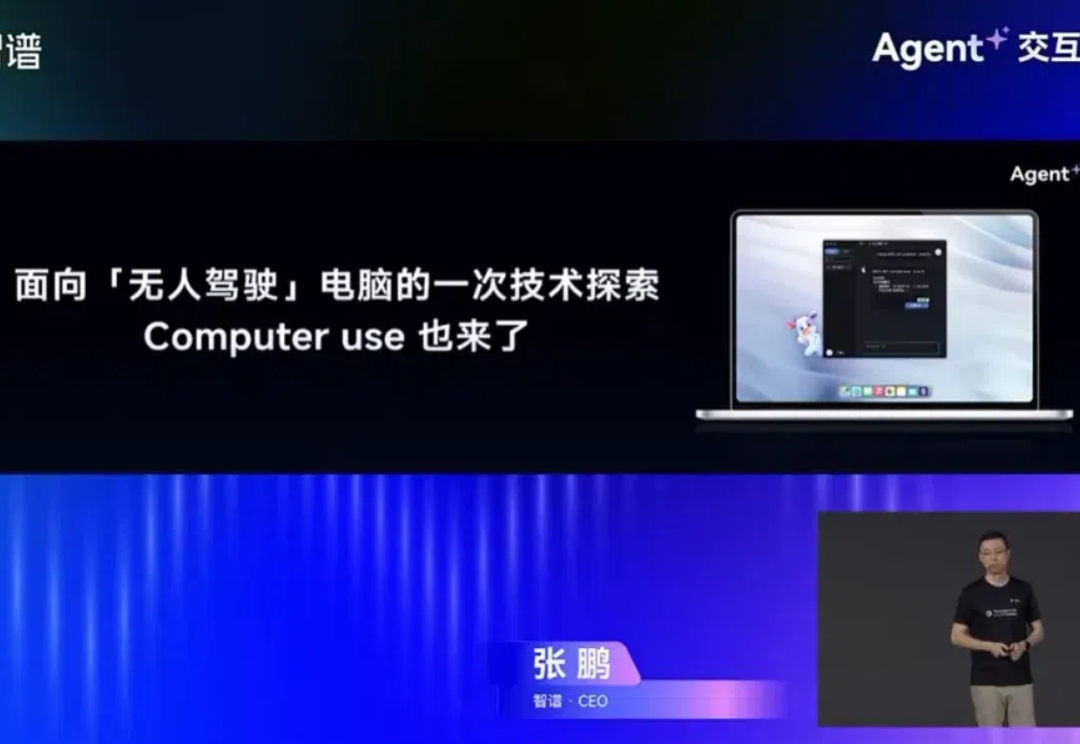

我们需要的是「真正解放双手的智能体」。 最近一段时间,大模型领域正在经历智能体(AI Agent)引发的革命。Anthropic 推出的升级版 Claude 3.5 Sonnet,一经推出即引爆了 AI 圈。